Maximaal SEO resultaat bij gepagineerde content

Paginering of gepagineerde content is het verdelen van content over meerdere pagina’s. Hoe ga je daar mee om vanuit zoekmachine optimalisatie (SEO) oogpunt? De belangrijkste SEO problemen en oplossingen van paginering op een rij.

Gepagineerde content?

Als je content verdeeld over meerdere pagina’s, noem je dat paginering of gepagineerde content. Het pagineren van content – ook wel paginatie genoemd – is niks anders dan het nummeren van pagina’s.

Gepagineerde content levert een aantal SEO problemen op. Alle pagina’s waarover de gepagineerde content verdeeld is, lijken namelijk meestal op elkaar.

Dat levert 4 SEO problemen op:

- Duplicate content

- Linkwaarde verspilling

- Crawl “budget” verspilling

- “Diepe” content onbereikbaar

Problemen & Oplossingen

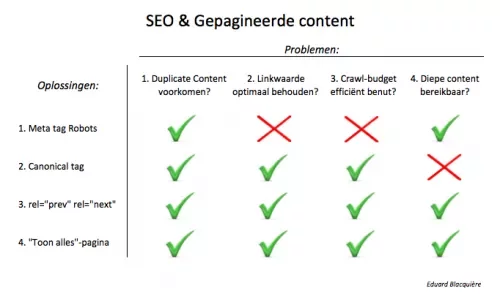

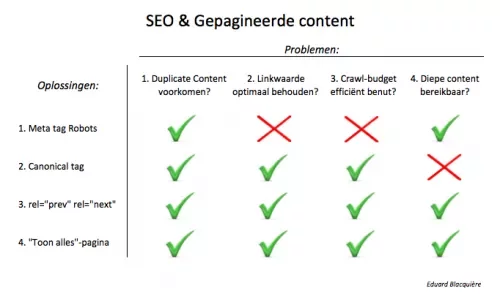

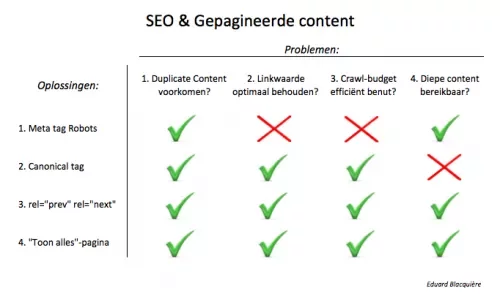

Hieronder beschrijf ik uitgebreid de SEO problemen en oplossingen voor paginering. Hierbij alvast in schema de problemen en oplossingen:

Schema SEO problemen en oplossingen gepagineerde content

1. Duplicate content

Duplicate content betekent dat dezelfde (of identieke) content bereikbaar is op meerdere pagina’s (= URL’s).

Zoekmachines zullen één URL kiezen en in de zoekresultaten tonen. De andere, dubbele URL’s worden uit de zoekmachine index verwijderd.

Duplicate content is niet het ergste probleem bij paginatie. Google en andere zoekmachines snappen dit steeds beter. En het is makkelijk op te lossen (bijvoorbeeld met een canonical tag, zie hieronder).

Minder crawlen

Een zorgwekkender gevolg van duplicate content is een crawl probleem: bij veel duplicate content besluit Google je site minder te gaan crawlen.

Google (en andere zoekmachines) volgen namelijk de redenatie dat alle identieke/dubbele content de site minder waard maken.

2. Linkwaarde verspilling

De verspilling van linkwaarde heeft een belangrijk negatief effect op je SEO resultaten.

Je wilt namelijk alle linkwaarde op – niet meer en niet minder dan – één unieke URL/pagina opbouwen. Maar bij gepagineerde content verdeel je de linkwaarde over meerdere, identieke pagina’s.

En dan krijgt elke pagina een beetje linkwaarde, waarmee geen van alle pagina’s een sterke basis heeft voor goede posities in de zoekresultaten.

3. Crawl “budget” verspilling

Een derde, minder bekend probleem, is de verspilling van je crawl “budget”.

Elke website heeft een maximaal crawl budget: het maximum aantal keer per periode dat jouw website gecrawlt wordt door een zoekmachine.

Factoren crawl & indexatie budget

Zoals alles bij Google (en andere zoekmachines) is niet precies bekend welke factoren meewegen.

Maar zeker is dat de autoriteit van jouw website doorslaggevend is. Simpel gezegd: het aantal links en de kwaliteit ervan. Google’s Matt Cutts bevestigde dit in maart 2010:

“… the number of pages that we crawl is roughly proportional to your PageRank”

(Bron: Stonetemple.com)

Hoe minder de PageRank of linkwaarde van een pagina, hoe minder deze gecrawld wordt. En hoe minder kans je maakt om in de index en dus in de zoekresultaten te verschijnen.

4. “Diepe” content onbereikbaar

Een 4e SEO probleem van gepagineerde content is dat zogenaamde “diepe” content niet bereikbaar is voor zoekmachines.

Stel, je hebt een webwinkel met een productgroep waar je heel veel artikelen van hebt, dan heeft de overzichtspagina van die productgroep veel gepagineerde content.

Artikelen die dan bijvoorbeeld op de 10e of 20e gepagineerde pagina staan, worden in het ergste geval niet meer gecrawld. Het resultaat: die artikelen zijn niet vindbaar in zoekmachines.

4 SEO oplossingen Paginatie

Voor de SEO problemen van paginering zijn 4 oplossingen te benoemen:

- Meta tag robots

- Canonical tag

- rel=”prev” & rel=”next”

- “Toon alles” pagina

1: meta tag robots

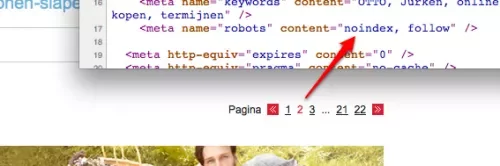

Een veel gebruikte SEO oplossing voor paginering is het gebruik van de meta robots tag met de waarde “noindex,follow” (vanaf gepagineerde pagina 2 en verder).

De meta robots tag plaats je per pagina in de head-sectie van de HTML.

Voorbeeld paginering met meta tag robots (noindex,follow)

Hiermee wordt alleen de 1e pagina in de gepagineerde serie geïndexeerd en de rest niet (door de waarde “noindex”).

Linkwaarde behouden

Als er vanuit de site (interne links) of van buiten de site (externe links) naar een gepagineerde pagina wordt gelinkt, behoud je de linkwaarde (door de waarde “follow”).

Alle linkwaarde die terecht komt bij pagina 2 en verder, wordt daar gewoon per pagina opgebouwd en doorgegeven aan de links op die pagina’s.

Bijvoorbeeld, bij een webwinkel met veel producten in een categorie worden producten die op gepagineerde pagina’s staan dus ook gewoon gecrawld.

Linkwaarde nog steeds verdeeld

Het duplicate content probleem is dus opgelost. Maar het linkwaarde probleem niet: je verdeelt nog steeds de linkwaarde over meerdere pagina’s.

Ook het crawl budget wordt niet efficiënt gebruikt. Alle gepagineerde pagina’s en de links daarop zullen zoekmachines dus blijven proberen te crawlen, waarmee je crawl budget wordt verbruikt door diepgelegen, minder belangrijke pagina’s.

Diepe content onbereikbaar

Wanneer er veel pagina’s aan gepagineerde content zijn, kan een zoekmachine besluiten te stoppen met crawlen. Daardoor kan het dus voorkomen dat verder gelegen vervolgpagina’s en de links op die pagina’s niet meer gecrawld worden.

Pagina’s die alleen gelinkt staan op verder gelegen vervolgpagina’s kunnen dan niet meer vindbaar zijn in zoekmachines.

SEO problemen opgelost?

Zijn de SEO problemen van paginering opgelost met de meta robots tag?

- Duplicate content: opgelost

- Linkwaarde verspilling: niet opgelost

- Crawl budget verspilling: niet opgelost

- Diepe content onbereikbaar: niet opgelost

Waarom geen robots.txt?

Ik heb weleens gezien dat robots.txt werd gebruikt om gepagineerde content te optimaliseren. Dit is echter geen ideale SEO oplossing voor paginering.Door het uitsluiten van gepagineerde content middels robots.txt blokkeer je het crawlen door zoekmachines. Dat lost duplicate content op, omdat Google die gepagineerde pagina’s nooit ziet. Ook het crawl budget wordt niet onnodig gebruikt.

De pagina’s die je in robots.txt uitsluit bouwen nog steeds linkwaarde op, maar deze autoriteit kan niet doorgegeven worden aan andere links. Dat is dus zonde. En diepe content is natuurlijk helemaal niet bereikbaar met robots.txt.

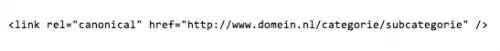

2: canonical tag

Een andere oplossing is de in 2009 door Google gelanceerde canonical tag (zie aankondiging Google).

De canonical tag plaats je per pagina in de head-sectie van de HTML.

Voorbeeld rel=”canonical”

Dit link element geeft aan waar de originele variant van een pagina/URL te vinden is. De canonical tag is bedoeld voor het oplossen van het duplicate content probleem.

Werking canonical tag

Het resultaat van de canonical tag is:

- Dubbele of identieke pagina’s worden uit de index verwijderd

- Alle link waarde wordt verzameld op de URL waarnaar je de canonical tag verwijst

- Pagina’s waarop de canonical tag staat worden nauwelijks meer gecrawld

Duplicate content is hiermee natuurlijk opgelost. Ook linkwaarde wordt verzameld en het crawl budget wordt efficiënt benut.

Er blijft echter een belangrijk probleem over: links op gepagineerde pagina’s worden nauwelijks meer gecrawld. En bij gebruik van de canonical tag wordt alleen de content geïndexeerd van de pagina waarnaar verwezen wordt.

Dus wanneer bijvoorbeeld sommige producten alleen te vinden zijn via gepagineerde pagina’s, dan zijn deze door de canonical tag zo goed als niet meer bereikbaar voor zoekmachines. Diepe content is dus niet bereikbaar met de canonical tag.

Wanneer niet gebruiken?

Zoals ik schrijf, heeft de canonical tag een duidelijk doel: duplicate content oplossen. Daarmee is de canonical tag NIET altijd geschikt voor het oplossen van gepagineerde content.

Als de gepagineerde content namelijk niet identiek is, heeft de canonical minder of – in het ergste geval -geen effect. Ik zie in de praktijk dat duplicate content dan wel verholpen is, maar dat niet alle linkwaarde optimaal wordt benut.

SEO problemen opgelost?

Zijn de SEO problemen van paginering opgelost met de canonical tag?

- Duplicate content: opgelost

- Linkwaarde verspilling: opgelost

- Crawl budget verspilling: opgelost

- Diepe content onbereikbaar: niet opgelost

3: rel=”prev” & rel=”next”

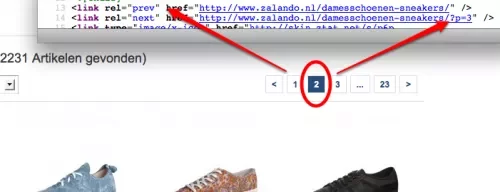

Sinds september 2011 is er de mogelijkheid om de SEO problemen van paginering op te lossen met de meta tags rel=”prev” en rel=”next”.

Deze elementen zijn al jaren onderdeel van de HTML standaard, maar Google gebruikt ze nu ook voor het oplossen van paginering problemen (zie aankondiging Google)

De meta tags rel=”prev” en rel=”next” plaats je in de HTML head van de gepagineerde pagina’s:

Voorbeeld paginering met rel=”prev” en rel=”next”

Met rel=”prev” en rel=”next” geef je aan dat er een relatie is tussen meerdere (gepagineerde) pagina’s. Wanneer je hiervoor kiest, doet Google het volgende:

- Linkwaarde van individuele gepagineerde samenvoegen aan toewijzen aan de hele serie/set van gepagineerde content

- De meest relevante pagina uit de serie indexeren, meestal de eerste pagina

Het duplicate content probleem is hiermee dus opgelost. En het belangrijke probleem van linkwaarde verspilling is ook opgelost.

Ook het crawl budget wordt nu efficiënt benut, omdat Google snapt dat de gepagineerde content bij elkaar hoort.

Google blijft de vervolgpagina’s echter nog steeds regelmatig crawlen, dus ook diepe content is en blijft bereikbaar.

Kanttekeningen

Belangrijk bij het gebruik van rel=”prev” en rel=”next” is dat URL parameters hetzelfde blijven voor alle pagina’s in de gepagineerde serie.

Weet ook dat Google het gebruik van rel=”prev” en rel=”next” ziet als sterke hint, maar niet altijd als opdracht opvolgt.

Het gebruik van rel=”prev” en rel=”next” is leidend ten opzichte van de “Toon alles”-pagina. Uitleg hierover volgt direct hieronder.

SEO problemen opgelost?

Zijn de SEO problemen van paginering opgelost met rel=”prev” en rel=”next”?

- Duplicate content: opgelost

- Linkwaarde verspilling: opgelost

- Crawl budget verspilling: opgelost

- Diepe content onbereikbaar: opgelost

Update:

Lees ook onze uitgebreide case over hoe Googlebot omgaat met rel=”prev” en rel=”next”.

4: “Toon alles”-pagina

Een eenvoudige, maar effectieve oplossing voor paginering is een “Toon alles”-pagina. Dit is een pagina die alle gepagineerde content op één pagina toont.

Als Google kan herkennen dat een gepagineerde serie ook een “Toon alles”-pagina bevat, dan doet Google het volgende:

- De linkwaarde van alle gepagineerde pagina’s in de serie wordt samengevoegd op de “Toon alles”-pagina.

- De “Toon alles”-pagina wordt (meestal) geïndexeerd en in de zoekresultaten teruggegeven.

Maar, let op: dit is geen garantie! Je laat de controle hiermee bij Google, terwijl je dit ook zelf in de hand kunt houden.

Canonical tag naar “Toon alles”-pagina

Om er zeker van te zijn dat Google altijd de “Toon alles”-pagina indexeert en altijd de linkwaarde samenvoegt op de “Toon alles”-pagina, is de canonical tag noodzakelijk.

Verwijs dan altijd met de canonical tag vanaf elke gepagineerde pagina in de serie naar de “Toon alles”-pagina.

Duplicate content is hiermee geen probleem meer, omdat Google altijd de “Toon alles”-pagina pakt.

Zoals gezegd, wordt ook alle linkwaarde benut en geconcentreerd op de “Toon alles”-pagina. Ook het crawl budget wordt efficiënt ingezet en alle diepe content is natuurlijk bereikbaar op de “Toon alles”-pagina.

Let op de laadtijd

Belangrijk is wel dat de laadtijd van de “Toon alles”-pagina niet te hoog is. Google geeft aan dat een laadtijd voor de “Toon alles”-pagina van ongeveer 3 tot 4 seconden prima is.

SEO problemen opgelost?

Zijn de SEO problemen van paginering opgelost met de “Toon alles”-pagina?

- Duplicate content: opgelost

- Linkwaarde verspilling: opgelost

- Crawl budget verspilling: opgelost

- Diepe content onbereikbaar: opgelost

Conclusie

Gepagineerde content, ook wel paginering, is het verspreiden van content over meerdere pagina’s (= URL’s). Dit levert 4 SEO problemen op: Duplicate content, Linkwaarde verspilling, Crawl “budget” verspilling en “Diepe” content onbereikbaar.

Beste SEO oplossing?

In dit artikel benoem ik 4 oplossingen voor de SEO problemen van paginering. In dit schema is te zien dat er 2 oplossingen alle problemen oplossen:

Schema SEO problemen en oplossingen gepagineerde content

Wel of geen “Toon alles”-pagina

De beste SEO oplossing voor gepagineerde content hangt af van de aanwezigheid van een “Toon alles”-pagina.

Is er een “Toon alles”-pagina aanwezig (en is de laadtijd 3 tot 4 seconden)?

- Ja:

Verwijs gepagineerde pagina’s met canonical tag naar “Toon alles”-pagina - Nee:

Gebruik rel=”prev” en rel=”next”

In beide gevallen is gepagineerde content geen SEO probleem meer, maar levert het juist maximaal SEO effect!

Een zoekmachine specialist inhuren? Huur dan een SEO specialist van OrangeValley